¿ Peligran nuestros puestos de trabajo?

El otro día vi esta charla en la que se hablaba de la posibilidad de que en un futuro no tan lejano las personas puedan ser sustituidas por las máquinas en sus trabajos. Lo cierto es que hace tiempo que llevo pensando en esto, y es que, aunque muchas veces no nos demos cuenta, las máquinas nos están ganando terreno, por ejemplo, en muchas farmacias existen los robots para coger los medicamentos, en las fábricas muchas tareas ya son realizadas por máquinas, incluso en nuestra casa podemos ver que los aspiradores ya funcionan solos.

En mi opinión, la innovación muchas veces nos hace caer en la deshumanización, hay personas que ya no encuentran empleo porque ese trabajo está realizado por una máquina, me parece bastante triste, la verdad. Se podría pensar “que se busque otro empleo” claro, es fácil decirlo, y además teniendo en cuenta la crisis de hoy en día, no es tan sencillo encontrar empleo , y como la cosa siga así, cada vez habrá más gente desempleada. Por ello, pienso que, de cara al futuro y teniendo en cuenta que la tecnología está cada vez más desarrollada, creo que serán necesarios otros puestos de trabajo más especializados en diseñar, y producir estas máquinas, así como otros puestos dedicados a su mantenimiento. Los puestos puramente técnicos serán sustituidos a la larga por las máquinas, y exigirá por tanto la creación de nuevos puestos trabajos más especializados que antes no existían.

Lo que siempre nos diferenciará de las máquinas son las emociones, si, existen prototipos de robots capaces de sentir emociones y transmitirlas, en este campo de la inteligencia artificial se está trabajando cada vez más pero están creadas a partir de algoritmos y datos que repiten constantemente, no son capaces de crear nada nuevo, sólo son capaces de copiar y ejecutar. El cerebro humano es único e inigualable, los humanos somos capaces de pensar por nosotros mismos, y de crear nuevos pensamientos e ideas, estamos innovando continuamente en nuestras cabezas.

La innovación va unida al desarrollo de la sociedad, y en la mayoría de las veces, mejora la calidad de vida de las personas, pero debemos preguntarnos también hacía dónde va esta sociedad en la que predomina el estrés, el individualismo y por desgracia, muchas veces, el sinsentido, donde no importan los valores y la educación y lo que más se valora es el dinero. En definitiva, me estoy dando cuenta que no es necesario que vengan las máquinas para deshumanizarnos, porque en cierta parte, ya lo estamos y cada día más…

Innovación en las carreteras españolas

El otro día, mientras hacía un viaje por una autopista con el coche cruzando España, se me encendió la reserva y, buscando una estación de servicio donde parar a repostar, se me ocurrió una idea que me pareció innovadora y viene a resolver un problema que me ocurre siempre cuando viajo con el coche.

Cuando voy por la carretera y tengo que parar en una gasolinera para echar gasolina, comprar algo o descansar, la señal de tráfico que indica que en la próxima salida hay una suele ser más o menos así:

El problema es que siempre me molesta mucho no saber de antemano si la estación de servicio está a pie de carretera, en el carril contrario o en un pueblo, por lo que habría que desviarse mucho o poco, lo cual supone una pérdida de tiempo muy grande, sobre todo en viajes largos. Me encantaría tener esta información de antemano con sólo mirar el cartel y, rápidamente (estamos hablando de viajes en autopistas, con una velocidad media de 110 km/ h, con lo que tomar estas decisiones rápidamente es vital), poder tomar la decisión de tomar la salida o no. Además, si sumamos el hecho de que casi todos echamos gasolina cuando se enciende la reserva, se hace todavía más necesario saber a que distancia está la gasolinera porque, aunque la mayoría de coches tiene una reserva de bastantes kilómetros, es bastante malo para el motor recorrer muchos kilómetros en reserva y esto puede provocar ansiedad y distracción, lo cual, obviamente, es muy negativo para la conducción.

Haciendo una sencilla búsqueda por internet, he podido ver en varios foros como la gente se pregunta también si hay algún método ya existente para obtener esta información, y he podido descubrir que es bastante recurrente la molestia de tener que desviarse para echar gasolina, tema aparte serían los coches eléctricos, ya que a día de hoy no existe infraestructura para recargar las baterías, mas allá de alguna ciudad. Muchos usuarios creen haber encontrado algún patrón más o menos recurrente relacionado con la distribución de los carteles señalizadores, o con la distancia a la que anuncian la salida, pero no hay un acuerdo evidente.

Intentando encontrar normativas o reglas acerca de si existe o no esta información, no he conseguido encontrar normativa, regulación o sistema que informe de a que distancia se encuentra la próxima parada.

Así que, ante tal problema, se me ha ocurrido una solución: Utilizar un sistema de señalización por colores que identifique cuan lejos está el área de servicio de la salida. De esta manera, se propone un sistema eficaz y eficiente para poder planificar con la antelación suficiente mientras se va conduciendo por la carretera, de manera que podamos tomar la decisión de salir en la próxima salida o no.

Se usarían pues 4 colores que indicarían esta información:

- Verde: La estación de servicio está a pie de carretera, bien en el mismo carril, o bien en el contrario, pero con posibilidad de volver al carril en el que estábamos.

- Amarillo: La estación de servicio se encuentra algo alejada del carril, máximo N kilómetros, donde N es un rango que habría que definir, cómo ejemplo propongo de 1 a 5 km.

- Naranja: La estación de servicio está más alejada que el nivel amarillo, pero menos que el nivel rojo, está a un rango M de kilómetros que, igual que antes, habría que definir. Yo propongo de 5 a 10 km.

- Rojo: La estación de servicio está muy alejada de la salida e integrada en una población.

Este sistema podría aplicarse en cada cartel de las carreteras de varias maneras, bien rediseñando los carteles actuales, o bien, como solución temporal, integrar unas pegatinas que se pondrían encima de los carteles ya existentes. Esta última solución es la más económica.

Adicionalmente, podrían incluir información de la siguiente área de servicio, con el sistema de colores propuesto, de manera que si yo veo que la más próxima es amarilla, pero la siguiente es verde y está lo suficientemente cerca, podría esperar. O por el contrario, si se me ha encendido la reserva hace bastantes kilómetros y veo la distancia de la siguiente área de servicio roja, o verde pero a una distancia lejana, probablemente decidiré salir por la siguiente aunque sea amarilla o naranja, ya que estaré menos tiempo en reserva.

¿Cuáles son los países más innovadores del mundo?

El Global Innovation Index (GII) llega a la 8ª edición con la publicación del informe correspondiente al año 2015. Se trata de una iniciativa conjunta de la Cornell University, la escuela de negocios INSEAD y la Organización Mundial de la Propiedad Intelectual (en inglés, World Intellectual Property Organization, WIPO). El núcleo del informe consiste en un ranquin de 141 economías mundiales a partir de sus recursos y resultados en el ámbito de la innovación.

El GII 2015 reconoce el papel clave de la innovación como motor del desarrollo y crecimiento económico. El informe tiene en cuenta 79 indicadores que van más allá de las medidas tradicionales de la innovación y que se pueden clasificar en 2 grandes grupos:

- Recursos: instituciones, capital humano, infraestructuras, desarrollo de los mercados y de las empresas.

- Resultados: conocimiento, tecnología y creatividad.

Según los datos del GII 2015, las 10 economías más innovadoras del mundo son, por este orden, Suiza, Reino Unido, Suecia, Finlandia, los Países Bajos, Estados Unidos de América, Singapur, Irlanda, Luxemburgo y Dinamarca. En conjunto, el grupo selecto de los 25 países punteros corresponde a economías de altos ingresos y, como en las ediciones anteriores, se mantiene bastante estable, hecho que pone de manifiesto la dificultad para alcanzar y superar los países líderes. Todo y con eso, merece la pena destacar los progresos de países como Irlanda (8ª) y la República Checa (24ª), así como los esfuerzos considerables de China (29ª) y Malasia (32ª). Por otro lado, el Estado español ocupa la 27ª posición mundial y la 18ª en el ámbito europeo.

Respecto a la calidad de la innovación, se evalúa a partir de los resultados de las universidades, la visibilidad de los artículos científicos y la dimensión internacional de las solicitudes de patentes. En este campo, las posiciones principales están ocupadas por los Estados Unidos de América y el Reino Unido, seguidos por Japón, Alemania y Suiza.

Para más información, podéis consultar la WEB del GII 2015.

Robots sexuales

Introducción

Recientemente estuve re-viendo un capítulo de Futurama titulado “Salí con una robot”. Futurama es una serie animada creada por Matt Groening, creador de la popular serie humorística Los Simpson. La serie sigue las aventuras de un repartidor de pizza, Philip Fry, que el 31 de diciembre de 1999 tropieza accidentalmente y cae por casualidad en una cápsula criogénica y despierta mil años después.

En el capítulo, el protagonista comienza una relación romántica con un robot con la forma de la famosa actriz Lucy Liu. A partir del momento en que esa relación se hace pública todos sus amigos (humanos y robots) se oponen totalmente a ella calificándola de antinatural. Es en ese momento en el que presentan un vídeo humorístico parodiando a los vídeos educativos de las escuelas, condenando que la gente mantenga relaciones sexuales con robots.

Incluyo el vídeo en inglés para amenizar el tema:

En las últimas décadas los avances en inteligencia artificial son increíbles: programas que participan en juegos de preguntas y que superan el test de Turing, algoritmos de visión artificial capaces de enfrentarse a imágenes como los tests de Rorschach, etc.

Añadamos a esto el desarrollo de robots humanoides en países como Japón, uno de los países con mayores avances en robótica. País dónde se han desarrollado robots capaces de tocar instrumentos, trabajar en hoteles y cuidar de personas.

Añadamos también la creación de piel sintética para prótesis que en el futuro sería indistinguible de la real.

Robots sexuales

No, no voy a hablar de las relaciones románticas que puedan establecerse entre humanos y robots, eso ya se ha tratado ampliamente en otros artículos. Además de producirse ya casos en el mundo actual, como el de Sal 9000, un nipón enamorado del personaje Nene Anegasaki del videojuego “Love Plus” con quien se casó en 2009.

La pregunta que yo me realizo tras analizar todo esto es “¿estamos tan lejos del momento en el que seres humanos y robots mantengan relaciones sexuales?”

Este tema no ha sido solamente tratado en la serie de Futurama. En la película Blade Runner se presenta un futuro en el que existen “replicantes”. Seres artificiales que imitan al ser humano en su aspecto físico y en su comportamiento, llegando a ser virtualmente indistinguibles. Estos seres artificiales se crean con diferentes modelos, entre otros obreros, soldados, comandos y trabajadores sexuales o modelos de placer. Igualmente en la película “Automata” protagonizada por Antonio Banderas aparece “un/a” robot trabajadora sexual.

¿Es por tanto esta idea tan descabellada?

El estado del arte

En el horizonte empieza a aparecer uno de los mercados posiblemente más fructíferos y rentables del futuro: el de los robots sexuales. Ahora parece una idea de Ciencia Ficción, pero ya se están sentando las bases para ello.

Un nuevo estudio titulado «Inteligencia Artificial, robótica y el futuro de los puestos de trabajo» asegura que en pocos años los robots coparán centenares de profesiones. El él se recoge la opinión de diversos expertos, la mayoría de los cuales creen que un día cercano estas máquinas desempeñarán más puestos de trabajo que en la actualidad están ocupados por seres humanos. Y gran parte de ellos no serán repetitivos empleos en cadenas de montaje sino que tendrán que ver con aspectos de la vida cotidiana, incluido el sexual.

Cada vez los robots son más parecidos a los humanos y por razones obvias, los diseñadores crean robots que deliberadamente tienen un aspecto joven y atractivo.

Un ejemplo de prototipo de robot cuya función futura puede ser el de sustituir a mujeres de carne y hueso ha sido creado en Japón y se llama Asuna.

Evidentemente Asuna no es un robot sexual pero los expertos dicen que es sólo cuestión de tiempo que este tipo de tecnología sea adaptada para tales fines. De hecho, hay empresas en Japón que ya están creando muñecas sexuales con una textura de piel tan perfecta que es “indistinguible de la real”. “Será posible mantener relaciones físicas con este tipo de androides”, sostiene Takahashi Komiyama, el portavoz de Ishiguro’s lab dónde se ha creado al robot Asuna. Una vez más Japón es una de los países más avanzados en este tema ya que cuenta con las muñecas sexuales más avanzadas del mundo, tales como las fabricadas por KanojoToys o por Orient Industry.

Por ahora, Asuna no está equipado con una inteligencia artificial avanzada o sistemas de reconocimiento de cara y voz. Sin embargo, se espera que una versión totalmente independiente se estrenará en 10 años, de la que se dice será casi idéntica a un ser humano, afirmó Takeshi Mita, CEO de a-Lab en Tokio.

Sin irnos aún de Japón, la cuestión del sexo con robots ha saltado a primer plano estos días por cuenta de Pepper, el popular humanoide doméstico que se vende desde hace tres meses y que es capaz de «leer» las emociones humanas. El fabricante, SoftBank, hace firmar a sus usuarios un acuerdo por el se comprometen a «no realizar un acto sexual o una conducta indecente con el robot».

Empresas como True Companion y Real Doll se encargan de fabricar robots destinados a usuarios que quieren tener ese tipo de relaciones sexuales, algo que probablemente irá a más y que algunos organismos quieren tratar de impedir.

En el portal studyweb.com se presenta un listado de 42 dispositivos electrónicos que existen para “tener sexo con ellos hoy“. Totalmente NSFW 😉

David Levy, autor del libro “Amor y Sexo con Robots”, dice que es inevitable que mucha gente acabe eligiendo a robots como amantes y cónyuges, ya que la tecnología está avanzando a pasos agigantados. “Yo creo que los robots sexuales serán una bendición para la sociedad”, dice. “Hay millones de personas ahí fuera que, por una u otra razón, no pueden establecer una buena relación”.

En 2015 se llevará a cabo el Segundo Congreso Internacional de “Amor y sexo con robots”. Quién esté interesado en participar puede enviar sus trabajos si están relacionados con los temas listados en su web: emociones en robots, robots clones de personas, robots de entretenimiento, enfoques afectivos a la robótica y ética en robótica.

¿Para cuando?

El sexo con robots será algo corriente para el 2050, incluso más común que el sexo entre humanos. La curiosa predicción la hace el futurólogo y matemático británico Ian Pearson, fundador de la firma Futurizon, con un 85% de exactitud en sus predicciones. David Levy anteriormente mencionado, asegura que en pocos años veremos evolucionar las versiones «crudas» que ya existen en «robots sofisticados que serán de uso común».

Según el futurista británico Ian Pearson, la evolución hacia el sexo con robots seguirán un proceso más o menos natural. En 2030 el sexo virtual en 3-D será tan ubicuo como lo es hoy por hoy la pornografía on-line. En 2035, la mayoría tendremos juguetes sexuales para interactuar con la realidad virtual. Una minoría podrá permitirse entonces el lujo de contar con robots sexuales en sus casas, hasta que se popularicen su precios y su uso.Pearson afirma además que el mercado de todo lo relacionado con el sexo será hasta siete veces mayor que hoy en día. Y el sexo con robots será posiblemente más frecuente que el sexo entre humanos.

«Mucha gente tendrá al principio reservas a mantener relaciones sexuales con un robot», admite Pearson. «Pero conforme vaya mejorando el comportamiento mecánico, la inteligencia artificial y la apariencia de las máquinas, los prejuicios se irán evaporando y la gente acabará conectando emocionalmente con los robots».

Voces a favor

Según explica el futurólogo Ian Yeoman en una conferencia en la feria australiana de Turismo recogida por el portal First To Know, las prostitutas robot podrían llegar a ser preferidas por los clientes porque evitarían el contagio de enfermedades de transmisión sexual como el VIH.

¿Parece todo esto demasiado sórdido y deshumanizado? El sexólogo estadounidense Ian Kerner ha dado una vuelta de tuerca más a este tema al sugerir que sería aceptable crear un tipo de androide ideado para que los hombres «practicasen» antes de tener sexo con una mujer y que ayudase a aquellos que padeciesen, por ejemplo, eyaculación precoz.

“Como terapeuta, no puedo sugerir en la actualidad un sustituto del sexo que sea legal. Por ello, y si hay madres de alquiler, me pregunto por qué la Inteligencia Artificial no puede ocupar ese lugar”, ha determinado Kerner.

En este sentido, el terapeuta ha señalado que, en un futuro no muy lejano, los autómatas serán un «sustituto del sexo» que ayudará a los hombres más tímidos a «practicar» antes de mantener una relación con una mujer de carne y hueso. «Crearlos permitiría a aquellos que tienen poca actividad sexual aprender a relajarse y, en un futuro, mantener relaciones con eficacia», ha destacado.

Por otro lado, Kerner planteó la posibilidad de que los «robots sexuales» podrían ayudar a determinados delincuentes. «El pedófilo es alguien con unos gustos sexuales que van en contra de los valores de la sociedad, la IA podría ser útil para que estos sujetos expresasen su sexualidad en la intimidad». En este sentido, los presentes señalaron que los autómatas podrían ser utilizados por los pedófilos de la misma forma que se utiliza metadona para tratar a los drogadictos.

Ante los diversos ataques de campañas en contra del desarrollo de estas tecnologías Douglas Hines, CEO de True Companion se defendió en los siguientes términos ”No estamos reemplazando a una esposa o tratando de sustituir a una novia». «Esta es una solución para gente que está entre dos relaciones o para alguien que ha perdido a su esposa… La gente puede encontrar la felicidad y sentirse llena de formas alternativas a la interacción humana».

Voces discordantes

Las ideas presentadas anteriormente por Kerner fueron criticadas duramente por sus colegas invitados a la mesa redonda, quienes señalaron que estos “robots sexuales! podrían causar dependencia a los nuevos jóvenes. Si hay una generación que crece con juguetes sexuales inteligentes que aprenden y tienen capacidad para satisfacer sus preferencias, podría ser que estas personas no entrasen en contacto físico con otros seres humanos”, explica en la conversación Gareth Price, graduado en IA por la Universidad de Manchester.

Dado el hecho de que la mayoría de las naciones no tienen leyes establecidas para limitar el sexo con robots y puesto que es un negocio potencial que puede ofrecer tantos beneficios, muchos expertos pronostican que las “relaciones” con androides sexuales pronto se convertirá en algo común.

Para la antropóloga Kathleen Richardson, de la Universidad de De Montfort en Leicester, estamos sin embargo en los albores de «una terrible pesadilla«. Richardson y otros expertos en ética robótica han lanzado la Campaña contra los Robots Sexuales y han reclamado a sus potenciales usuarios que «examinen sus conciencias», antes de contribuir al desarrollo de una tecnología con imprevisibles consecuencias en la vida real. En un estudio la autora expone que «las relaciones de prostitución con máquinas no son ni éticas ni seguras. El desarrollo de robots sexuales reforzará aún más las relaciones de poder que no reconocen a ambas partes como sujetos humanos».

Reflexiones éticas

En todas esas conversaciones hay cada vez una reflexión más profunda sobre la Ética Robótica y lo que nosotros mismos sentimos hacia las máquinas. Comienzan a explorarse debates por parte de gente que ama a los robots y quiere defender sus derechos, el efecto que los robots pueden causar en nosotros y sobre todo el que podrían causar si alguna vez toman conciencia de sí mismos, algo que parece aún estar muy lejos de nuestra realidad.

Todos estos debates no parecen frenar unos avances que dejan claro que hay mucho terreno por delante en todo lo relacionado con la robótica. Y desde luego también en esa rama de la robótica del placer, que a buen seguro se convertirá en una alternativa relevante para millones de personas en todo el mundo.

¿Puede la ciencia ficción predecir el futuro… de la innovación?

“Los límites de lo posible sólo pueden ser definidos yendo más allá,

hacia lo imposible” Arthur A. Clarke (1917-2008)

A lo largo del máster se ha hablado mucho de la innovación tecnológica y de como ésta se sirve de la Ciencia para progresar. Pero lo que me gustaría plantear en este post es ¿puede también la ciencia ficción servir como fuente de inspiración para innovar?

En los libros y en las películas de ciencia ficción se describen sociedades que han alcanzado unos logros científicos y técnicos hipotéticos. Esto da pie a idear otros mundos muy diferentes al que conocemos actualmente, con objetos y situaciones imaginarias que no se pueden alcanzar por no existir la tecnología adecuada para ello (por lo menos, en el momento de su creación). Sin embargo, la idea está ahí y se difunde públicamente, lo que puede dar pie a investigaciones e invenciones que sí son reales. Éstas, a su vez, abren la posibilidad de imaginar una tecnología más avanzada. De esta manera, se podría decir que sí existe una relación entre la Ciencia y la ciencia ficción.

Entonces, ¿puede la ciencia ficción predecir cómo va a ser la tecnología del futuro? Vamos a ver algunos ejemplos en los que escritores y directores dan en el clavo y anticipan invenciones mucho antes de que estas se convirtieran en algo cotidiano. Al fin y al cabo, la realidad supera la ficción.

Julio Verne (1828-1905)

Julio Verne fue uno de los primeros visionarios en obras clásicas como Veinte mil leguas de viaje submarino, Viaje al centro de la Tierra, La Isla Misteriosa, De la Tierra a la Luna, entre otras.

En ellas, Verne imagina ciudades iluminadas por luces eléctricas de gran potencia, habla de un sistema de comunicación a distancia automático y secreto (similar al correo electrónico de hoy en día), de submarinos, helicópteros y trasatlánticos, de retransmisión de noticias (las primeras noticias por radio no serían retransmitidas hasta 1920) e incluso sobre viajes a la Luna, todo ello a finales del s XIX.

George Orwell (1903-1950)

Otro autor que también se anticipó a su tiempo fue George Orwell. En su obra 1984 expone un mundo que es constantemente vigilado a través de un sistema de cámaras de videovigilancia muy avanzado, diseñado por el Gobierno para controlar a los ciudadanos.

JG Ballard (1930-2009)

JG Ballard describió en su ensayo de 1977 una aproximación a lo que hoy conocemos como redes sociales:

«Cada una de nuestras acciones durante el día, a lo largo de todo el espectro de la vida cotidiana, será instantáneamente grabada en video. Por la noche nos sentaremos a ver las imágenes, seleccionadas por una computadora entrenada para elegir sólo nuestros mejores perfiles, nuestros diálogos más inteligentes, nuestras expresiones más afectuosas, capturadas a través de los filtros más amables, y luego juntaremos todo ello para tener una reconstrucción mejorada de nuestro día».

Metrópolis (Fritz Lang, 1927)

Metropolis es un clásico cinematográfico del género de ciencia ficción y posiblemente la primera película en la historia del cine en la que aparece un androide o robot antropomórfico. Se trata de un SER-MÁQUINA llamado “María”, que tiene la capacidad de suplantar el aspecto y el comportamiento de una persona. Son precisamente estas habilidades de transmitir sentimientos y amor los que caracterizan al personaje y por las cuales se convierte en la líder pacífica de los trabajadores.

En la actualidad, empresas como Hanson Robotics persiguen el sueño de construir androides con indicios de inteligencia y emoción humanos como Han, el robot más humano del mundo.

2001: Una odisea en el espacio (Stanley Kubrik, 1968)

La novela de Arthur C. Clarke fue desarrollada en paralelo a su versión cinematográfica y publicada poco después del estreno del film.

La película anticipa las órbitas geoestacionarias y su aplicación en el campo de las telecomunicaciones, así como la inteligencia artificial gracias al superordenador HAL9000, encargado de controlar las funciones vitales de la nave Discovery.

A lo largo del viaje espacial también se puede ver cómo los personajes utilizan videoconferencias entre ellos e interactúan con pantallas táctiles.

Como curiosidad, los abogados de Samsung no tardaron en darse cuenta del parecido que tienen estas pantallas táctiles con el actual Ipad, para utilizar la película de Kubrik como defensa en el juicio por violación de patentes entre Apple y Samsung.

Como curiosidad, los abogados de Samsung no tardaron en darse cuenta del parecido que tienen estas pantallas táctiles con el actual Ipad, para utilizar la película de Kubrik como defensa en el juicio por violación de patentes entre Apple y Samsung.

Regreso al futuro II (Robert Zemeckis, 1989)

Posiblemente todos recordemos las aventuras y desventuras de Marty Macfly en sus viajes en el tiempo gracias al entrañable Doc.

Concretamente en Regreso al Futuro II el protagonista viajaba a octubre de 2015, un mundo futurista con aeropatines, coches voladores y paseadores de perros. Aunque no todas las predicciones sobre el futuro se desarrollaron como Zemeckis se imaginaba en 1989, sí que dió en el clavo en otras como la videollamada o la tecnología de huellas digitales.

Casualmente (o no), Lexus presentó este mismo año un modelo funcional del aeropatín o Hoverboard que utiliza Marty para desplazarse en la película. Podéis verlo en el siguiente enlace.

Casualmente (o no), Lexus presentó este mismo año un modelo funcional del aeropatín o Hoverboard que utiliza Marty para desplazarse en la película. Podéis verlo en el siguiente enlace.

Minority Report (Steven Spielberg, 2002)

En este caso el propio Steven Spielberg consultó cómo sería el futuro con un equipo de expertos futuristas, entre ellos científicos informáticos, filósofos, artistas y arquitectos para dirigir la película. “Quería que todos los juguetes se hicieran realidad algún día”, afirmó Spielberg en una entrevista con Roger Ebert, crítico de cine.

A lo largo de la película aparecen invenciones que se han hecho muy populares durante los últimos años, como la publicidad programática, los escáneres de retina, las interfaces multitáctiles o el software de predicción de delitos.

La trilogía Matrix (Wachowski, 1999-2003)

Seguramente recordaréis esta trilogía, mucho más reciente. En ella se representa un futuro distópico en el que lo que se percibe como realidad es una mera simulación virtual, que fue creada por máquinas sensibles al apoderarse de la población humana.

Aunque no se ha llegado al nivel de realidad virtual que se alcanza en la trilogía Matrix, actualmente ya existe la tecnología Oculus Rift que genera prácticamente la sensación de estar inmerso en otro mundo. Y sigue evolucionando.

HER (Spike Jonze, 2013)

La película tiene lugar en un futuro cercano, en el que el protagonista se enamora de un sistema operativo (Samantha) basado en el nuevo modelo de Inteligencia Artificial, diseñado para satisfacer todas sus necesidades. Durante la película, la tecnología está presente en todas partes y se activa por voz, incluyendo a la propia Samantha, su asistente personal.

¿Qué es real? Ya existen asistentes automáticos que se activan por voz, como Google Now y Siri, aunque evidentemente no tienen todas las capacidades que muestra Samantha en la película. Hay muchas aplicaciones móviles que a día de hoy tienen la posibilidad de funcionar a través de la voz.

Pero lo que me gustaría destacar sobre esta película es la interpretación que hace el científico y futurista Ray Kurzweil de la misma, que sostiene que el mundo será así en 2029 (podéis acceder en este enlace, eso sí está en inglés). Es más, afirma que el hecho de que Samantha no tenga cuerpo no será un problema en un futuro, sino que se podría solucionar fácilmente implantando, por ejemplo, una lente que permita proyectar imágenes en la retina.

Para los que no lo conozcan, Kurzweil es uno de los tecnólogos y especialistas en inteligencia artificial más reconocidos del mundo. Sus teorías suelen generar mucha controversia, ya que está convencido de que no habrá distinción entre máquinas y humanos dentro de pocos años.

Para los escépticos sobre este tema, es muy recomendable ver la entrevista (especialmente a partir del minuto 11.40) que le hace Punset en su programa Redes, donde explica las teorías de cómo el hombre evolucionará trascendiendo la biología y se fusionará con la tecnología en un futuro no muy lejano. En otras palabras, el ser humano será capaz de desarrollar tecnologías que mejoren notablemente sus capacidades, tanto a nivel físico como biológico, para superar sus propias limitaciones humanas y llegar a controlar la propia evolución como especie. La realidad ya dejaría de existir tal y como la conocemos, convirtiendo a la especie humana en seres con extensas capacidades, merecedores de la etiqueta «posthumano«.

¿Parece increíble, verdad?

La robótica modular

Aunque en este blog se ha hablado mucho sobre la innovación en el mundo de la robótica, me gustaría añadir un artículo más sobre el tema, sobretodo porque muchas veces, al hablar de robótica, uno se olvida de los robots modulares, pequeños desconocidos a los que muchos solo conocen de obras de ficción.

Mucha gente, cuando piensa en los robots, piensa en ellos como una sola entidad, un solo robot con una forma específica que esta preparado para realizar un conjunto de tareas concretas. Aunque la definición es correcta, contiene uno de los mayores inconvenientes de los robots, que solo están diseñados para tareas concretas y definidas. Estas tareas pueden ser muchas y muy variadas, pero siguen siendo limitadas. Por ejemplo, un brazo robotico puede ser programado para realizar múltiples tareas, pero no puedes pedirle que haga nada que su forma le impida, como subir escaleras.

Para intentar sortear esta limitación, se pensaron los robots modulares, robots formados por robots mucho más pequeños, idénticos en forma y tamaño, que pueden cambiar de posición y combinarse entre ellos para adaptarse a cualquier situación. Todos estos robots funcionan de forma independiente a sus colegas y utilizan señales para mantener conversaciones entre ellos y saber así, desde su posición relativa dentro del robot, hasta si hay algún problema con algún robot del conjunto o la nueva forma a tomar.

Por ejemplo, es posible que los robots modulares más conocidos sean los de ficción, como el t-1000 de la película «Terminator 2», que podía cambiar su forma y color a voluntad, o los robots que utiliza el villano de la película de Disney «Big Hero 6», que al cambiar de forma permitían al usuario darles miles de aplicaciones prácticas. Si bien es cierto que la tecnología actual esta aún muy lejos de producir robots como los mencionados por limitaciones de hardware, hoy en día universidades y empresas de todo el mundo están innovando en el mundo de la robótica modular.

Los problemas a los que se enfrentan los investigadores de robots modulares son principalmente 2: la velocidad de movimiento de los robots y la vida de su fuente de energía. Algunos robots actuales pueden tardar hasta 10h en cambiar totalmente su forma y si estos son muy complejos o deben ejercer mucha fuerza, consumen enseguida su fuente de alimentación.

Aún así las ventajas de los robots modulares son enormes, imaginaos puentes capaces de cargar con el peso de camiones fabricados en minutos a partir de un par de cajas de módulos roboticos, escaleras de incendio camufladas como elementos decorativos de la fachada de un edificio que cambian de forma y se muestran como escaleras cuando detectan una emergencia, detección de personas enterradas en derrumbamientos de edificios a base de escurrirse entre los escombros o incluso se podrían arreglar robots dañados cambiando los módulos averiados por módulos nuevos. Cualquier cosa es posible siempre que se tengan a mano suficientes módulos.

Veamos algunos ejemplos:

M-BLOCK

Un ejemplo de estos módulos es el M-Block, del MIT. Cubos que son capaces de conectarse entre si y de moverse de forma independiente mediante saltos calculados (sí, los cubos saltan, literalmente) para aterrizar en su posición decidida por el el conjunto de módulos.

KILOBOTS

Los Kilobots, de la Universidad de Harvard, son pequeños robots con sensores infrarojos capaces de formar cualquier figura conexa a base de moverse por el perímetro del conjunto de Kilobots y de detenerse en la posición que les corresponde.

MTRAN3

Por último me gustaría mostrar uno de mis favoritos, el MTRAN3, de AIST y Tokyo-Tech fabricado en 1998. Estos módulos son como juntas o bisagras conectadas por sus extremos y equipadas con sensores para detectar colisiones que permiten, cambiando la forma del robot, arrastrase como una serpiente, caminar como una araña o incluso a cuatro patas, pudiendo sortear problemas como escalones de diferentes tamaños.

El futuro de los robots modulares

Lamentablemente las limitaciones del hardware, tanto por el tamaño de los elementos necesarios como por su potencia y su consumo de energía, han dejado la investigación con robots modulares relegada a un segundo plano hasta que se encuentren soluciones viables. A penas un pequeño puñado de empresas y universidades siguen investigando en este campo tan interesante a nivel teórico, como el caso de NASA, o realizando pequeñas demostraciones con robots de diferentes formas y tamaños capaces de realizar tareas de cambio de forma.

Aún así, una vez pasada esa barrera, se esperan grandes cosas de la robótica modular y de sus posibles aplicaciones tanto en empresas como en el día a día.

MACHINE LEARNING

Sería allá por el año 2002 cuando por primera vez formé parte de un equipo de I+D aplicada, cosa que no se ha vuelto a repetir hasta ahora y difícilmente creo que se vuelva a dar. Como soy licenciado en informática, obviamente, mi campo era la I.A. En concreto nos centrábamos (si es que se puede decir que estábamos centrados en algo) en los siguientes campos:

- Representación del Conocimiento

- Sistemas expertos

- Redes neuronales

- Árboles de toma de decisiones

- Programación declarativa

Sí compañeros, como podéis ver le dábamos a casi todo por aquel entonces. Digamos que aquello era una “rave” del procesamiento computacional. La cosa que más me chocó de todo, fueron los sistemas expertos y las redes neuronales, por la capacidad de aprender que tienen. Uno de estos sistemas es capaz de tomar decisiones a través del aprendizaje y que resulta relativamente sencillo de implementar eran los sistemas expertos, en los cuales, simplemente tenías que definir un conjunto de probable de entrada y darle una salida correcta.

Obviamente, a medida que el sistema empieza a aprender, comete muchos errores en función de que la muestra de “entradas conocidas” sea más o menos amplia y de que su distribución sea uniforme a lo largo de la población muestreada. Una vez que vamos corrigiendo errores en la salida, el proceso va almacenando dicho conocimiento, añadiéndole un peso a cada condición de entrada respecto a la salida esperada. Una vez que crece el conocimiento heurístico que el sistema es capaz de almacenar, es capaz de anticipar salidas desconocidas según el escenario de entrada.

Me hacía gracia pensar que un sistema experto está un poco vivo, en tanto en cuanto tenía que aprender y que cuanto más tiempo dedicábamos a enseñarle más rápido aprendía y mejor lo hacía… tal y como una mascota o un ser humano. Pero lo que sucede en realidad no es algo tan mágico, es mucho más simple, una inferencia estadística según un escenario inicial y una salida con una probabilidad de éxito.

Recientemente me he vuelto a topar con esta rama de la I.A., concretamente con el machine learning y me he acordado de lo que hacía y así he podido comparar cómo han avanzado los algoritmos computacionales.

Estamos en la era de los datos, sólo que los datos que se tratan ahora son datos no estructurados. Son Terabytes de información que se obtienen de distintos orígenes, el mundo de la integración de sistemas y estaba claro que para explotar dicha información necesitábamos dotar al hardware de un mecanismo para ello. Es aquí donde el machine learning toma importancia, ya que es capaz de inferir información concreta sobre una base de información sin estructurar, o lo que es lo mismo, es capaz de inducir conocimiento de, por ejemplo, textos descriptivos.

Esto sirve para cosas tan complejas como clasificar comportamientos o características y como podéis imaginar la aplicación es la que quieras dar al resultado de dicha información, desde sectorizar o predecir comportamientos ya sean de personas u otro tipo de entidades que nos proporcionan información.

Nosotros, en concreto, nos centramos en la sectorización empresarial por la actividad desarrollada según descripciones obtenidas por distintos medios. De esta forma, nos hemos decantado por algoritmos de máquinas de vectores de soporte (SVM) y por clustering.

Son los algoritmos SVM los que mejores resultados nos han proporcionado en la clasificación y su funcionamiento es muy sencillo. De momento sólo estamos utilizando esta técnica para deducir a qué sector pertenece una empresa. Como los sectores empresariales se solapan (la misma empresa puede estar en dos sectores al mismo tiempo), no podemos crear un único modelo, sino que debemos crear un modelo por cada sector y aplicárselo a todas las empresas.

Para ello cogemos un sector determinado y un conjunto de entrenamiento formado por empresas que pertenecen al sector, cuanto mayor sea el conjunto de entrenamiento mejores resultados nos dará el algoritmo, pero también podemos suministrar en nuestro conjunto de entrenamiento empresas que no pertenecen al sector, ya que también el sistema aprende de los casos negativos. Nos está dando muy buenos resultados y una vez generados los diccionarios es realmente rápido. Para que entendáis mejor cómo se realiza la vectorización de un texto os pongo el siguiente ejemplo:

- texto1: “La casa verde”

- texto2: “El perro de la casa

Construimos primero nuestro diccionario:

la => 1, casa => 2, verde => 3, el => 4, perro => 5, de => 6

Hemos construido un diccionario de 6 dimensiones. Ahora podemos vectorizar los textos, donde cada dimensión corresponde a una palabra del diccionario:

- texto1 => (1, 1, 1, 0, 0, 0)

- texto2 => (1, 1, 0, 1, 1, 1)

Para obtener mejores resultados, se pasa toda el texto a minúsculas, se quitan tildes y caracteres especiales, se eliminan las stopwords (palabras más comunes del idioma, en nuestro ejemplo serían: la, el, de) se lematizan todas las palabras (eliminando plurales, declinaciones, conjugación de verbos, etc.) y se utilizan bigrams o trigrams (conjuntos de 2 o 3 palabras seguidas).

Obviamente un algoritmo de extracción de keywords (palabras clave sobre la información de una entidad concreta) nos permitiría tener un diccionario mucho menor y así obtener mucho mejores resultados a la hora de aplicar el algoritmo SVM, que es en lo que ahora estamos trabajando.

También estamos intentando afinar un algoritmos de clustering que nos permita extraer agrupaciones de la población de entidades que manejamos, para obtener automáticamente los sectores sugeridos por el sistema.

De este modo entre unos y otros algoritmos podemos llegar a tener unos resultados muy eficientes.

Es ahora cuando asusta ver que una máquina puede aprender mucho más rápido que nosotros y dar mejores resultados, lo que me tranquiliza al final es que por mucho que aprenda, jamás entenderá la información de una manera lógica y por mucho que sea capaz de deducir, inducir o reducir, no se dejará llevar por la intuición ni tomará conciencia de sus actos o existencia, vamos que la era de Skynet aún se me antoja lejana…

Bibliografía

Para desarrollar esto me he apoyado en algunas entradas de la Wikipedia, pero sobre todo os he buscado enlaces de interés para que podáis ahondar más en un tema que considero realmente apasionante:

- Representación del Conocimiento https://es.wikipedia.org/wiki/Representación_del_conocimiento

- Sistemas Expertos https://es.wikipedia.org/wiki/Sistema_experto

- Redes Neuronales https://es.wikipedia.org/wiki/Red_neuronal_artificial

- Árboles de toma de decisiones https://es.wikipedia.org/Árbol_de_decisión

- Programación declarativa https://es.wikipedia.org/wiki/Programaci%C3%B3n_declarativa

- Machine Learning https://es.wikipedia.org/wiki/Aprendizaje_automático

- SVM https://es.wikipedia.org/wiki/Máquinas_de_vectores_de_soporte

- Extracción de keywords https://www.airpair.com/nlp/keyword-extraction-tutorial

- Clustering https://es.wikipedia.org/wiki/Algoritmo_de_agrupamiento

LIDERAR EN TIEMPOS REVUELTOS

LIDERAR EN TIEMPOS REVUELTOS

Francesc Vineglas

Una de las cuestiones básicas por no decir trascendentales que creo que deben darse en el proceso de innovación es un buen lideraje, hasta el punto estoy convencido de esta afirmación que sin líder no hay innovación, el talento requiere de alguien que sepa localizarlo, gestionarlo y enfocarlo a una finalidad concreta y especifica, sino se pierde.

Siempre se ha tenido una visión del lideraje muy psicológica, centrada en características y aptitudes innatas materializándose en personas de carácter y capacidades extraordinarias que con sus iniciativas y ejemplo han conducido a los demás por los derroteros del

beneficio común, no voy a ser yo quien desmienta esta visión del lideraje como monopolio de ciertos individuos para ver mas allá, dirigir de manera más efectiva o canalizar los deseos y esperanzas, sin embargo, sin olvidar que hay parte de razón en el planteamiento anterior pienso que liderar es cuestión de oportunidad y conocimiento y bajo este ángulo se puede aprender a liderar, es como si la psicología nos hubiera enseñado que hay hombres extraordinarios pero por otra parte y desarrollando ya conceptos de la Ilustración que somos muy parecidos, y bajo esa premisa objeto de estudio y a partir de ahí nace este concepto de aprendizaje de unas habilidades para conseguir un objetivos, en este caso liderar.

Aquí os dejo un cuestionario para evaluar vuestras capacidades para liderar y ver que os sobra o falta para conseguir ser un buen líder.

How Good Are Your Management Skills?

Hacer click en el enlace http://www.mindtools.com/pages/article/newTMM_28.htm

para abrir el recurso

Ética e Innovación

En los últimos tiempos, igual que en este curso, la innovación esta en boca de todos. Todos hablan de innovación y emprendeduría como una manera de salir de la crisis, como una manera de generar nuevos valores que permitan a las empresas ser más competitivas y en general con multitud de calificativos positivos. La mayoría vemos la innovación como la panacea para muchos de los problemas. A menudo, sin embargo, parecemos olvidar las repercusiones que pueden tener las innovaciones en la vida de las personas, en la sociedad. Y uso el término repercusiones sin pretender asignar el calificativo despectivo que en ocasiones se asocia con esta palabra. Lo hago de esta manera para intentar mostrar que, aunque al hablar de innovación pocas veces se habla de ética, quizás el innovar deba conllevar una evaluación de las repercusiones que dicha innovación puede tener sobre la sociedad.

Así pues, se plantean las siguientes preguntas: ¿Porque es necesaria la ética en la innovación? ¿Debe la ética parar el progreso? Por supuesto no se trata de preguntas fáciles de responder, pero día a día llegan a nuestros oídos dilemas éticos relacionados con la innovación y es a posteriori cuando llegan estas preguntas. ¿Podría se quizas interesante unir la reflexión ética a la innovación?

Entendemos la ética como la rama de la filosofía que estudia el bien y el mal y sus relaciones con el comportamiento humano, con la moral. Una definición semejante de la ética pudiera parecer que no tiene cabida en el mundo actual, donde los conceptos de valor o desvalor quedan diluidos entre principios religiosos, políticos, sociales y económicos. Sin embargo, el sentido ético se podría presentar de forma simple entre el valor de beneficio y el desvalor de perjuicio para la sociedad y las personas. Por supuesto, dado que nada es blanco o negro, ninguna de estas evaluaciones se ofrece sencilla. Y dado que nada es neutro, es difícil alcanzar este valor o desvalor sin considerar los intereses en juego y la influencia que éstos puedan tener en este resultado final del beneficio/perjuicio.

A título de ejemplo, a todos han llegado noticias del cambio climático y las medidas recomendadas a fin de detenerlo. Encontramos noticias como las que se muestran en el siguiente link:

http://elpais.com/elpais/2015/09/11/ciencia/1441978325_897742.html

Esta noticia ofrece una medida para combatir el cambio climático si los líderes mundiales no son capaces de llegar a un acuerdo. Sin embargo, desconocemos que repercusiones reales pueden tener estas sombrillas sobre el ecosistema completo del plantea tierra. Atreviéndonos a ir todavía un poco más lejos: ¿no hubiese sido mejor llevar a cabo una evolución, una innovación, sostenible en lugar de llegar a este punto de casi no retorno? Aún más, ¿no hemos aprendido nada de la trayectoria que nos ha llevado al estado actual? Es decir, si hasta ahora la evolución tecnológica, realizada sin evaluar detenidamente las consecuencias, nos ha conducido a un punto en el que es necesario instalar sombrillas solares, quizás sería recomendable evaluar las implicaciones éticas de colocar este par de sombrillas a modo preventivo.

Por supuesto las innovaciones tecnológicas no alcanzan únicamente al sector energético o medioambiental. En los últimos años venimos contemplando una intromisión cada vez mayor en la vida personal de todos los individuos. Sin embargo, en el momento en el que aparecieron las innovaciones de las redes sociales y del Internet de las cosas, no se plantearon los problemas que ahora empiezan a aparecer. Una reflexión a tiempo sobre estos problemas quizás no hubiese evitado llegar a los extremos presentes puesto que en estos casos el bien que proporcionan las redes sociales parece superar sus efectos adversos. Por otro lado, sí que hubiese permitido estar más preparados para afrontar los problemas que más tarde han aparecido y para algunos de los cuales se ha legislado rápida e ineficientemente:

http://www.abc.es/tecnologia/noticias/20150615/abci-derecho-olvido-201506151117.html

http://abcblogs.abc.es/ley-red/public/post/el-desordenado-panorama-del-derecho-al-olvido-15932.asp/

http://politica.elpais.com/politica/2015/01/23/actualidad/1422015745_590889.html

Queda claro que al hablar de innovación no hablamos únicamente de nuevos productos. En otros campos podemos encontrar ejemplos de “innovación” caso de:

Parece curioso encontrar noticias como estas en un mundo en el que se lucha por la igualdad entre mujeres y hombres, así como por la dignidad de las personas. La dignidad de los individuos es, sin duda, uno de los puntales que debe evaluarse desde la perspectiva ética para decidir si un proyecto debe o no seguir adelante.

Habrá quien defienda que si una innovación no supone un beneficio para la sociedad esta no va a ser aceptada. A no muchos años vista tenemos el caso de las gafas de google y todos los problemas que plantearon. Al final parece que su salida al mercado se demoró y que provocó muchas polémicas como la que se muestra:

http://tecnologia.elpais.com/tecnologia/2014/01/21/actualidad/1390299676_075132.html

En este caso la polémica se encendió antes de que las gafas llegaran al gran público, sin embargo no pasa lo mismo con otras innovaciones. La pregunta que deberíamos plantearnos entonces es: ¿Todo vale cuando hablamos de innovación? Quizás deberíamos hacer un esfuerzo por vincular la innovación de empresas, instituciones y particulares, por vincular la ética a los proyectos de innovación.

Resulta exigible que la ética obligue a aplicar un principio de prevención y precaución apriorístico a toda posible innovación.

El principio de prevención o precaución se evalúa por factores previos sencillos que obligan a entrar a la ética, como al valor superior de la dignidad de la persona. El primer principio es que los principios de prevención o precaución atienden a una ecuación sencilla, el progreso y los avances tecnológicos tienen como destinatario a las personas, y en tal ecuación las personas no son el objeto o conejillo de indias de tales avances, sino el sujeto, la piedra angular. Los avances pretenden su beneficio en todos los sentidos, dentro del respeto de tal valor central, respeto a su vida, a su integridad física y psíquica, pero también a su intimidad y a su propia libertad decisión.

Por tanto, la exigencia de prevención o precaución parte de la premisa de que el avance tecnológico no puede comportar un riesgo no asumible por estos valores de la persona. Y para saber el nivel de riesgo y su afectación a estos valores, lo primero exigible es el propio conocimiento del riesgo existente, el grado o nivel de riesgo que conlleva. El avance tecnológico debe ser capaz de generar suficiente conocimiento de sí mismo, de tal modo que se pueda evaluar su nivel de riesgo en el entorno y en la realidad de las personas e incluso otros seres vivos y bienes relevantes.

En la medida que los avances tecnológicos no cumplen tales premisas entra en juego la ética y la dignidad de la persona. El desconocimiento de riesgo y su afectación sobre la persona y el resto de seres vivos hace que se estos se conviertan en instrumentos y objetos de evaluación del riesgo. Los convierte en instrumento, conejillos de indias, puesto que serán los que sufrirán tales consecuencias y los que darán a conocer el nivel de riesgo padecido, sufrido por dicha injerencia tecnológica.

Y esto dará lugar a que a la hora de evaluar el bien representando por la persona y el resto de seres vivos, o el bien representado por el propio avance tecnológico, predomine éste último.

http://blog.inerciadigital.com/2013/06/25/vertederos-tecnologicos/

Día a día nos encontramos con problemas relacionados con la tecnología y con los avances tecnológicos. La innovación se ha convertido en una parte muy importante de la sociedad en la que vivimos. Si aceptamos esto como cierto, deberíamos aceptar también que es importante entender qué repercusiones va a suponer una innovación para la sociedad. Es aquí donde se puede llegar a la conclusión de que la ética es importante para la innovación. A la pregunta de si la ética debe parar la innovación no daré respuesta, lo dejo a la opinión del que lea esto. Lo único que planteo es que detenga o no la innovación, una reflexión sobre la implicaciones, positivas o negativas, de un proyecto innovador, podrían permitir que la sociedad estuviese mejor preparada para aceptar los cambios que se avecinan.

Terminando, si los ejemplos expuestos, los diversos argumentos o el sentido común no fuesen suficientes para apoyar la tesis de que la ética debe ir unida a la innovación, la comisión europea, tiene en cuenta estos aspectos a la hora de definir sus planes de investigación y desarrollo y a la hora de definir los planes de ayuda como Horizonte2020.

http://sociedad.elpais.com/sociedad/2013/04/30/actualidad/1367342938_884354.html

Así pues, parece que la política ya esta tomando las primeras medidas relativas a este aspecto, ¿creéis que las empresas comparten este punto de vista?

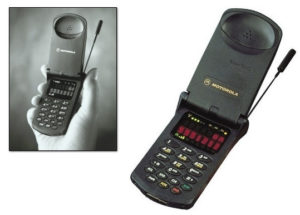

Nuestros Smartphones

Tal y como viene siendo habitual en mis artículos de debate en Linkedin el tema de esta entrada trata sobre el mundo de la tecnología móvil, en una breve introducción de cómo los móviles han cambiado nuestra vida, para posteriormente explicar a qué podremos optar en un futuro próximo con nuestro teléfono así como los usos actuales que también tienen y que resultan sorprendentes o curiosos.

Así pues, a día de hoy es normal la imagen de un grupo de personas o amigos mirando sus móviles sin levantar la vista, ir en el metro sin saber quién está a tu alrededor, hay muchos ejemplos. El caso es que se ha convertido en un instrumento que influye en nuestra manera de relacionarnos con los demás, ya sea amigos, familia, pareja o conocidos.

Lo cierto es que esta adicción está totalmente ligada al impacto que ha supuesto esta tecnología en la sociedad y al emergente crecimiento de las apps para móviles ha cambiado la forma de hacer muchas tareas diarias como por ejemplo comprar o simplemente leer las noticias.

Todo este efecto ha provocado que muchas empresas hayan decidido sacar productos (con mayor o menos éxito) que ayudan a la gente a desintoxicarse propiamente de su smrtphone. Como ya hemos visto en otros artículos que he compartido en Linkedin, desde la famosa empresa australiana que desarrolla un pimentero que apaga los dispositivos móviles en la mesa, hoteles que ofrecen dejar su móvil bajo llave hasta el término de sus vacaciones, aplicaciones que miden tu grado de adicción al móvil o los carriles peatonales para personas que van por la calle utilizándolo.

Por otro lado, la futura llegada de la tecnología 5G asegura unas comunicaciones tan rápidas que permitirán ampliar notablemente el uso del teléfono a otros aspectos de la vida diaria y también el desarrollo real del llamado Internet de las Cosas. Por ejemplo la posibilidad de informar a través del móvil de accidentes de tráfico, atascos, estado de las infraestructuras mediante multitud de sensores conectados, posibilidad de descargar películas en tu teléfono, manejar máquinas a distancia, en definitiva, multitud de nuevas posibilidades al poder reducir el tiempo que tarda la información en llegar de un lugar a otro. Aquí tenemos algunos ejemplos más.

Sin embargo, a pesar de todo esto, que llegará en un futuro próximo, actualmente un smartphone nos ofrece muchas posibilidades: realmente lo sorprendente viene cuando uno descubre la gran variedad de aspectos en los que un teléfono inteligente puede ser de utilidad, casi siempre solamente mediante las apps que puedes instalar o en otras ocasiones en asociación con otros aparatos.

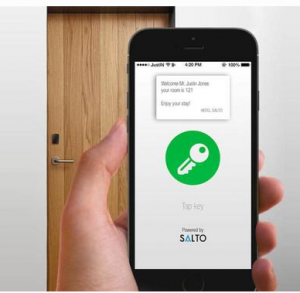

De hecho, aunque antes hayamos visto que hay hoteles que nos dan la posibilidad de desconectar de nuestra tecnología móvil durante las vacaciones, abrir la propia habitación de un hotel con el teléfono móvil ya es posible La compañía española Salto System ha desarrollado la tecnología necesaria tanto en la parte de la cerradura de la puerta como la app necesaria para ello, gestionando esta comunicación bien mediante Bluetooth o bien mediante NFC y almacenando la información necesaria con un cifrado de datos. Aunque todavía no es algo que esté totalmente extendido la empresa está instalando actualmente esta tecnología.

Más sorprendente resulta el uso del smartphone en el ámbito de la medicina. Así mismo, un móvil con microscopio es capaz de detectar parásitos en la sangre. Un equipo de científicos de la Universidad de Berkeley ha desarrollado una nueva herramienta denominada como “CellScope” que se incorpora en un teléfono móvil y mediante vídeo detecta y cuantifica automáticamente (en un lapso de dos minutos) de qué infección parasitaria se trata utilizando únicamente una gota de sangre. Este estudio, que ha sido publicado en la revista Science Translational Medicine, detalla que el dispositivo mueve la muestra de sangre delante de la cámara del teléfono y un algoritmo analiza de forma automática el movimiento de los gusanos. Unos minutos después, se visualiza en la pantalla el recuento de los gusanos y su tipología.

Siguiendo con el uso del smartphone en el ámbito médico, un grupo de ingenieros de la Universidad de Columbia (EE.UU.) ha conseguido simplificar la costosa prueba para detectar la presencia del virus del sida o de la bacteria sífilis en nuestra sangre. Todo se ha reducido a un simple pinchazo en el dedo, un pequeño dispositivo con un coste de menos de 30 euros y un smartphone. Su funcionamiento es muy sencillo: obteniendo la sangre el pinchazo, se deposita la muestra en el accesorio que se conecta al smartphone realizando un triple test de anticuerpos, los del VIH, los específicos para la sífilis y otros utilizados para detectar esta infección bacteriana. El resultado puede obtenerse en 15 minutos.

Desde esta manera, con estos avances que hemos visto, los diagnósticos de laboratorio se pueden hacer accesibles para casi cualquier población con acceso a un teléfono inteligente.

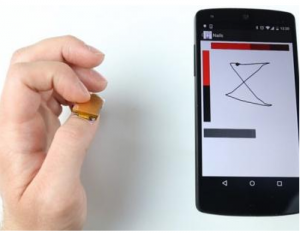

Otro invento con bastantes aplicaciones para el futuro es el de un grupo de investigadores del Instituto Tecnológico de Massachusetts han ideado un pequeño dispositivo portátil que se coloca sobre el pulgar y que lo convierte en un dispositivo de control inalámbrico con la idea de que el usuario pueda manejar de este modo distintos aparatos y con capacidad para programar distintos patrones de movimiento. El prototipo, que se llama «NailO», permitirá por ejemplo enviar un mensaje a través del teléfono o navegar entre varias aplicaciones o pantallas mientras estás cocinando o hablando por teléfono.

Incluso la marca de cosmética L’Oréal Paris ha presentado una tecnología que permite el reconocimiento facial en movimiento. Esta app consigue que los usuarios prueben los productos de maquillaje en tiempo real y en movimiento mirándose al espejo de realidad virtual de su móvil o tableta. La herramienta se basa en un algoritmo obtenido tras el análisis de miles de rostros de distintas etnias. En esencia, funciona con un mapeo facial que capta 64 puntos de la cara y 100 expresiones faciales distintas. Para desarrollar esta aplicación, que cabe destacar que se encuentra en el top 5 de descargas en EEUU), L’Oréal ha colaborado con una empresa especializada en el reconocimiento facial. Una tecnología similar ha sido empleada en la película “El Curioso Caso de Benjamin Button” o en el famoso videojuego “Grand Theft Auto V” para conseguir rostros más reales.

Por último, y a modo de curiosidad, nuestro teléfono ya nos da hasta la posibilidad de colaborar con proyectos científicos: “Science in your Mobile” es una app desarrollada por la fundación Ibercivis y la Universidad de Zaragoza que permite a sus usuarios colaborar en la investigación de varios proyectos científicos que presenta al usuario en forma de juego.

Otra aplicación muy parecida es “Samsung Power Sleep”. Si nos descargamos esta app para Android, cuando no estemos usando el teléfono, este será utilizado para procesar datos obtenidos de experimentos, por lo que cuanta más gente se sume a esta iniciativa, menos tiempo se tardará en dar sentido a todos esos datos que se obtienen a diario. Aquí podéis ver el vídeo.

En definitiva, con todo esto queda demostrado el importante papel que juega actualmente nuestro teléfono móvil en la vida diaria y también su presencia en los proyectos de innovación que se realizan en diferentes sectores.

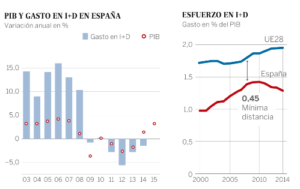

Metodología para evaluación de convocatorias de ayuda a la I+D+i

¿Cuántas veces hemos oído que la I+D+i tiene que estar apoyada desde la alta dirección de la empresa? ¿Cuántas convocatorias de ayudas con bases de cientos de páginas hay disponibles?

Una de las labores principales de un Tecnólogo es identificar a qué convocatoria convocatoria de ayudas presentarse y exponer a la dirección los motivos que han llevado a tal decisión para obtener la necesaria esponsorización. Esta entrada pretende identificar los puntos principales que permitan comunicar nuestras razones en un documento de no más de una página o en una exposición de no más de 5 minutos.

No se pretende realizar un análisis detallado de la convocatoria ni mucho menos decidir la participación definitiva en la convocatoria sino pasar un primer filtro y poder responder a la pregunta ¿merece la pena invertir un minuto más en esta convocatoria?

He identificado tres áreas principales a revisar cada una de ellas con varios campos según el esquema que se muestra a continuación:

1. Introducción a la convocatoria:

1. Introducción a la convocatoria:

- Nombre y tipo de ayuda (Pública Europea, Pública Nacional, Pública Regional o Privada)

- Información de la convocatoria: Contacto, web, etc

- Breve descripción de la convocatoria

- Documentación de referencia

2. Encaje con la convocatoria:

- Lugar, fecha y descripción de la documentación a presentar

- Tecnología de la empresa aplicable

- Beneficiario de la ayuda: Empresa individual, consorcio, otros

- Duración del proyecto

- Encaje con topic, alcance e impacto esperado

- Criterios de evaluación de la convocatoria

- Posibilidad obtención ayuda

- Incompatibilidad con otras ayudas. Requisitos de la empresa

3. Evaluación preliminar de recursos y financiera

3. Evaluación preliminar de recursos y financiera

- Modalidad de financiación: Préstamo, subvención, beneficios fiscales, etc… y sus condiciones. Presupuesto mínimo y/o máximo

- Resultado de la evaluación económica preliminar. Evaluación económica en página aparte

-

Estimación RRHH necesarios para realizar el proyecto y preparar la oferta

De todos los campos que se muestran en el esquema quiero llamar vuestra atención sobre algunos de ellos:

- Breve descripción de la convocatoria: Uno de los primeros consejos que recibí, y que recuerdo constantemente, al empezar a trabajar con normativa es: «Lo más importante de una Norma es el título». Las convocatorias tienen bases de cientos y cientos de páginas, esta extensión e información masiva no debe hacernos nunca perder la orientación que proporciona el título de convocatoria. En este punto yo suelo indicar el título de la convocatoria incluyendo alguna breve explicación en caso que la terminología empleada no sea familiar para el lector.

- Encaje con topic, alcance e impacto esperado: Este es, mi opinión, el punto clave. Si nuestra idea o producto no encaja con los objetivos, alcance e impacto esperados por la convocatoria no merece la pena presentarse. En caso de no tener un buen encaje y justificación no hace falta dedicar ni un segundo más al estudio. Si hay dudas se puede consultar, para proyectos europeos o o similares se puede contar con la ayuda del personal del CDTI. Esta consulta a especialistas sería un «MUST» en caso que se deciera proceder con la presentación a la convocatoria.

- Incompatibilidad con otras ayudas. Requisitos de la empresa: Filtro Si-No generalmente fácil de verificar y puramente objetivo. Esta características hacen que este aspecto sea fundamental y uno de los principales motivos para que nos tiren por tierra nuestra perfecta respuesta a cualquier otro requisito de la convocatoria.

- Resultado de la evaluación económica preliminar: No se pretende realizar un estudio pormenorizado simplemente un resumen de cómo serían los «números gordos» del proyecto. No creo que se pueda conseguir una apoyo de la dirección sin un balance positivo y creíble aunque preliminar del proyecto.

- Estimación RRHH necesarios para realizar el proyecto y preparar la oferta: En el presupuesto se deben haber identificado los recursos humanos necesarios para la realización del proyecto para valorar el coste de los mismos. Quisiera remarcar aquí, la no menos importante capacidad y la planificación necesaria para preparar la documentación necesaria. Ya se que es difícil, pero de las estadísticas de entrega de documentación se desprende que todo se hace en el último momento y espero estéis de acuerdo conmigo en que las prisas no son buenas.

Al final de la ficha recomiendo incluir una línea resumen de la evaluación del departamento de I+D+i y otra en la que se refleje la decisión final de la empresa para futuras referencias. Estas fichas pueden formar parte del registro de Vigilancia Tecnológica de vuestra empresa de acuerdo a lo requerido por la norma UNE 166002.

Espero que esta guía pueda servir a alguien en su trabajo diario y, por supuesto, os invito a todos a compartir vuestras experiencias y a incluir cualquier comentario o reflexión.

Innovación en la forma de adaptarse

Hace años cayó en mis manos un libro que cambió mi manera de ver el proceso de desarrollo del software y, en general, cualquier proceso de construcción de algo, incluso vital. El libro era «UML y patrones» de Craig Larman y me proporcionó una visión (creo que) muy acertada sobre cómo enfocar la construcción de algo: paso a paso, adaptándose al cambio y siempre buscando soluciones.

Donde dije digo…

Esto es lo primero que debemos asumir, el cambio. Da igual que te estén contruyendo un complejo sistema software que sirviendo una ración de calamares. Algo no te va a gustar y vas a querer cambios. Esto es una condición inherente al ser humano y a la comunicación. No es posible comunicar el 100% de lo que queremos comunicar. Por ponerlo simple, entre la cabeza del emisor, el método de comunicación (verbal, chat, email…) los ojos u oídos del receptor y su cabeza, hay un montón de puntos donde el mensaje se corrompe. Para evitar esos saltos en el entendimiento, es aconsejable seguir algunas buenas prácticas.

En definitiva, el cambio llegará, por muchos esfuerzos que hagas, así que prepárate para afrontarlo.

Gestión de la espectativa

Muy relacionado con lo anterior. Si pediste una ración de calamares y el camarero te dijo que «es una ración grande» y luego te trae un plato con 3 calamares, es probable que tu decepción se vea incrementada con buenas dosis de cabreo (legítimo cabreo, eso sí). Y es que para que un cliente, un amigo, un compañero de trabajo, en definitiva, alguien que espera algo de tí se vea razonablemente satisfecho, es necesario gestionar correctamente aquello que espera. En este punto, en el mundo empresarial, especialmente en el de las consultoras, surge el eterno conflicto entre marketing y realidad. Marketing suele prometer más de lo que la realidad puede dar y de ahí muchas de las decepciones.

Under promise, over deliver

O dar un poco más de lo que espera el cliente. Ojo, no confundir con sobreestimar. Se trata de prometer algo factible y aunque la entrega se retrase, añadir algún valor a dicha entrega para que la sensación sea mejor.

Hace unas semanas encargué por Internet comida para mi perra. Al dia siguiente recibí un email diciéndome que se habían quedado sin existencias, que tardarían 2 días más, pidiéndome mil disculpas por ello. Como no tenía urgencia, no me importó, así que no cancelé el pedido. Cuando llegó, junto al pienso, me habían incluido unas cuantas golosinas que mi perra agradeció mucho. Detalles que hacen que la promesa incumplida no sea tan dolorosa y evitan la pérdida de un cliente. Incluso fideliza. Los restaurantes llevan toda la vida haciéndolo con los chupitos tras la cuenta.

Nobody cares about the thing you’ve designed, unless you can get them past the beginning.

https://medium.com/the-year-of-the-looking-glass/design-the-beginning-b8e61081ce42

En este artículo se habla sobre la importancia de la primera impresión que causa en el cliente la presentación de un nuevo producto. Es algo clave despertar ese interés inicial para que haya siguientes pasos en la comunicación que permitan concretar una venta. Algunas preguntas que debe hacerse un buen vendedor:

- ¿Dónde y cómo será la primera comunicación sobre el producto con el cliente? Es importante que el lugar sea adecuado, que sea tranquilo y agradable y permita centrar la atención de a quien dirigimos la exposición.

- ¿Cuáles son los puntos clave a dar a conocer? Deben estar claros y fácilmente entendibles y seguibles.

- ¿Qué es lo que verán en el primer minuto? ¿Cómo planeas hacer la demostración? Como pierdas la atención pronto, no habrá ya forma de arreglarlo.

- ¿Cómo será la expansión social del producto? Es importante diseñar el grafo social antes de que éste se cree sin control. Para ello es útil elegir buenos #hashtags, dominios, slogans, etc.

- ¿Qué es lo que hará volver a tus clientes una segunda o tercera vez? Este punto sea quizá el más importante porque es la clave de que todo lo anterior haya servido de algo.

Satisfacción, UX y feedback

Hay multitud de aspectos relacionados con la satisfacción del cliente, pero creo que centrarse en el comienzo de la experiencia de usuario puede ser la clave del éxito. Ahí tenemos los ejemplos de Apple y sus productos que, a pesar de ser notablemente más caros, siguen vendiendo muchísimo debido a la satisfactoria experiencia de uso de sus clientes.

Por último, el feedback o retroalimentación es básico para poder reconducir el producto hacia lo que realmente necesita o desea el cliente. Es conocido el artículo del modo en que contruye Spotify sus productos (https://dl.dropboxusercontent.com/u/1018963/Articles/HowSpotifyBuildsProducts.pdf). Aquí se habla de formas de llevar a cabo las ideas, de promover la creación de las mismas por parte de todos los implicados en el proceso de creación y de cómo evaluar cuáles merecen la pena y cuáles no. Muy recomendable.

Gestión del tiempo

Como extra, un comentario que me acaba de hacer un compañero sobre que se le va el tiempo entre correos electrónicos, llamadas, reuniones, etc. La conversación ha derivado en lo mal que solemos gestionar el tiempo y la poca importancia que le damos a lo importante frente a lo urgente. Os dejo 2 imágenes que se explican por sí solas.

Sobre la gestión del tiempo.

Sobre la prioridad de los asuntos que ocupan nuestro tiempo.

Ya lo dice Fito: «no siempre lo urgente es lo importante». Es importante mirar este cuadrante antes de planificar tareas.

En resumen, que aunque algunas de estas técnicas tienen ya su recorrido y no se pueden llamar innovadoras, la aplicación de las mismas a día de hoy, sí me parece que pueda tener más por hacer, porque veo que en muchos casos, seguimos atascados en los mismos agujeros de siempre. Espero que este repaso sirva para que muchos de vosotros os planteéis si realmente estáis gestionando bien vuestro tiempo, si enfocáis vuestro esfuerzo en lo que realmente importa, el cliente o si vendéis adecuadamente entre otras cosas.

Energía, Innovación y Medio Ambiente

La economía mundial está cada vez más interrelacionada. La protección del clima y la conservación de los recursos son también dos asuntos cada vez más internacionales y hoy en día se les concede una prioridad absoluta en muchos países. Esto hace aumentar la demanda de productos innovadores que contribuyan a proteger el medio ambiente.

La economía mundial está cada vez más interrelacionada. La protección del clima y la conservación de los recursos son también dos asuntos cada vez más internacionales y hoy en día se les concede una prioridad absoluta en muchos países. Esto hace aumentar la demanda de productos innovadores que contribuyan a proteger el medio ambiente.

En un mundo donde las necesidades energéticas son cada vez mayores, la inversión en investigación y desarrollo se ha convertido en un factor clave para dar solución a los grandes problemas a los que se enfrenta el ser humano. El medio ambiente y la ecología afloran como impulsores de la innovación y el emprendimiento.

Sin embargo, aunque parece que todo el mundo “rema hacia la misma dirección”, el equipo legislativo español parece estar pensando en otras cosas. En el presente artículo analizaremos estas cuestiones.

El caso del «impuesto» Tesla

Baterías Tesla. Fuente

Recientemente (véase noticia y noticia) salió a la luz la existencia de un borrador de Real Decreto que incluye una nueva tasa para los usuarios que se conecten a la red eléctrica nacional y tengan además sistemas privados de almacenamiento de energías renovables. Esto parece una medida disuasoria y preventiva hacia las baterías Tesla, que tanta repercusión están teniendo tanto a nivel internacional como nacional, y hacia el autoconsumo eléctrico.

La alegación del gobierno al respecto, es porque la generación distribuida de electricidad (que es como denomina el Real Decreto al autoconsumo de los usuarios) no reduce necesariamente los costes de mantenimiento de las redes de transporte y distribución, ni otros costes del sistema eléctrico que deben ser cubiertos con cargo a los ingresos del sistema, y en algunos casos podría provocar costes de inversión adicionales en las redes para adecuarlas a las necesidades de esta nueva generación.

Por esta razón, al consumidor, con independencia de la modalidad de autoconsumo (salvo en caso de instalaciones aisladas e independientes de la red eléctrica nacional), se le aplicará el término fijo del peaje de acceso por la potencia contratada y el término variable del peaje de acceso por la energía consumida.El Gobierno además recuerda que será necesario tener en cuenta los costes y cargos asociados a la provisión por servicios de respaldo que requiere el sistema para garantizar tanto el balance entre generación y demanda en el horizonte diario y en tiempo real.

Impuesto solar. Hipo Popo Pota Tamo by Ramón

Esto es cierto, la red nacional necesita tener capacidad para dar suministro siempre a todos los usuarios conectados, tengan autoconsumo o no. Pero ¿justifica esto el gravamen? Respondamos a esta pregunta analizando los datos de generación eléctrica por parte de las energías renovables (en concreto el sol) y los consumos de los hogares españoles que nos muestran en esta web.

Demanda eléctrica vs generación eléctrica. Las subastas

Una familia en España, puede intentar adaptar sus consumos eléctricos a la producción solar, mediante sistemas de encendido automático de electrodomésticos, uso de agua caliente cuando los depósitos solares están cargados,… Pero a pesar de esto, sigue habiendo momentos en que se necesita luz cuando no se produce energía. En la siguiente imagen se muestran unos datos estimados de consumo para una vivienda unifamiliar en España (área degradada en azul).

Producción solar vs demanda energética familiar. DBM Ingeniería

En esta imagen, se pueden ver los consumos medios domésticos en España repartidos a lo largo del día. Si además solapamos la curva de producción solar, se observa claramente como una gran parte de la energía producida sería desaprovechada de no existir algún sistema de almacenamiento, mientras que buena parte del día (en concreto la noche) no se podría llevar una vida normal si no es con un aporte extra (ya que no hay producción energética solar).

Propuesta regulatoria

Tal y como está planteado el Real Decreto actual o las anteriores propuestas, se está disuadiendo a cualquier posible usuario de autoconsumo o inversor de invertir en energías renovables que reduzcan su propio consumo energético, ya que los costes fijos (que son los más caros) no se verían afectados por la inversión y se mantendrían igual. También se disuade al posible inversor de auto-producir energía, debido a los recargos que conlleva. Además, el exceso de energía no se contempla el verterla en la red de Red Eléctrica Española.

Por tanto, mi propuesta es fomentar en vez de restringir, limitar o desincentivar. Pero fomentar el uso según las propias necesidades del sistema nacional, en vez del sistema propio. Y en caso de que se quiera cobrar por el mantenimiento de las redes y la disponibilidad de servicio (como está reflejado ahora en los Reales Decretos), se debería hacer sobre la energía comprada a la red, incentivando que esta sea la menor posible, y obligando a vender la energía cuando la red nacional lo necesite (por medio de acumulación en baterías por parte del usuario).

El Medio Ambiente como restrictor

Protocolo de Kioto

El Protocolo de Kioto sobre el cambio climático es un protocolo de la Convención Marco de las Naciones Unidas sobre el Cambio Climático (CMNUCC), y un acuerdo internacional que tiene por objetivo reducir las emisiones, en un porcentaje aproximado de al menos un 5 %, dentro del periodo que va de 2008 a 2012, en comparación a las emisiones a 1990, de los seis gases principales del efecto invernadero que causan el calentamiento global:

Protocolo de Kioto

- dióxido de carbono (CO2),

- gas metano (CH4) ,

- óxido nitroso (N2O),

- hidrofluorocarburos (HFC),

- perfluorocarbonos (PFC),

- hexafluoruro de azufre (SF6).

Protocolo de Kioto

En general el Protocolo de Kyoto es considerado como primer paso importante hacia un régimen verdaderamente mundial de reducción y estabilización de las emisiones de gases de efecto invernadero. Y proporciona una arquitectura para cualquier acuerdo internacional sobre el cambio climático que se firme en el futuro. El Protocolo ha movido a los gobiernos a establecer leyes y políticas para cumplir sus compromisos, a las empresas a tener en cuenta al medio ambiente a la hora de tomar decisiones sobre sus inversiones, y además ha propiciado la creación del mercado del carbono.

El protocolo de Kioto, acabó oficialmente en el año 2012, pero sigue utilizándose, y en Europa se ha heredado la estrategia 20-20-20, que básicamente pretende reducir un 20% la emisión de gases de efecto invernadero, tener un 20% de producción renovable y mejorar un 20% la eficiencia energética.

Medio Ambiente como impulsor de la innovación

Existen muchas empresas que han utilizado innovación basada en el medio ambiente. Desde la mencionada al inicio del artículo, Tesla, hasta pequeños trabajadores, autónomos y PYMES. A continuación se describen algunos ejemplos.

DBM Ingeniería

DBM Ingeniería